Technische Dokumentation

Die technische Dokumentation beschreibt zum einen die Schritte, die automatisiert an den durch die Bearbeiter*innen manuell (XML-Editor Oxygen) gepflegten Ausgangsdaten („XML-Masterfassung“, s. Projekt- und Datengenese) vorgenommen werden, um diese in das Content Management System (Semantic MediaWiki) zu überführen, und zum zweiten die konkrete Implementierung des Inhaltsmodells im MediaWiki. Der Code hierzu ist in einem Github-Repositorium veröffentlicht.

Das Semantic MediaWiki (SMW) als Publikationsplattform und Content Management System (CMS)

Das Wiki basiert (zum Zeitpunkt der Erstellung des Berichts, 31.03.2021) auf MediaWiki 1.31 mit der Erweiterung Semantic MediaWiki 3.0 (SMW). Für die Präsentation der Inhalte und Generierung von Übersichten sind darüber hinaus die SMW-Erweiterungen Semantic Results Formats (3.1), Semantic Compound Queries (2.1) und Maps for MediaWiki (7.0) zentral.

Ziel der Überführung der Daten in ein CMS war,

- dass die Daten ohne größere technische Hürden durch die Bearbeiter*innen weiter gepflegt und ergänzt werden können,

- eine Präsentationsoberfläche auf der Basis einer langfristig unterhaltenen Software anzubieten und aufwändige Eigenentwicklungen zu vermeiden,

- schließlich den Zugang zu den überlieferten Berichten insgesamt zu vereinfachen.

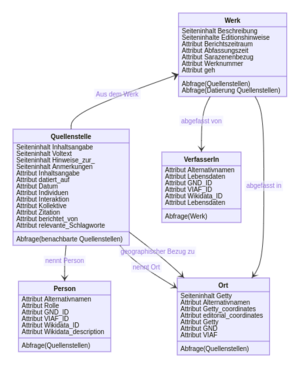

Ein zentrales Anliegen beim Einsatz der Erweiterung SMW war es, durch die Abbildung von Relationen über Attribute (engl. properties) die vielfältigen Verweise zwischen den Entitäten als Abfragen im Interface zu realisieren und damit die Fehleranfälligkeit bei manueller Pflege von Verlinkungen im Wiki zu reduzieren. Werke sind bspw. durch das Attribut „abgefasst von“ mit VerfasserIn-Seiten verknüpft. Auf diese Weise lassen sich durch eine Abfrage auf der VerfasserIn-Seite automatisch alle Werke auflisten, die der AutorIn zugeschrieben werden können. Weitere Inhalte/Entitäten können somit aufgenommen werden und fügen sich bei konsequenter Anwendung des angelegten Schemas von Relationen und Typisierungen in die jeweiligen Übersichten ein, ohne dass die Verlinkungen manuell gepflegt werden müssen. Ein zusätzlicher Mehrwert der Abbildung von Relationen in einem SMW entsteht durch die Möglichkeit, die Werte durch individuelle semantische Suchen abzufragen. Hier z. B: „Welchen VerfasserInnen wird mehr als ein Werk zugeschrieben?“ Weiterhin bietet die explizite Auszeichnung von Informationen durch Attribute (insbesondere in Kombination mit der Verwendung von Normdaten) prinzipiell das Potential der Anschlussfähigkeit der Daten an externe Ressourcen über einen einfachen RDF-Export.

Semantische Abfragen generieren nicht nur dynamisch alle tabellarischen Übersichten, sondern auch die Timelines zur Datierung auf Werk-, Quellenstellen- und Zeitraumübersichtsseiten (Datierung, Abfassungszeitraum) und die Kartendarstellungen zur Geolokalisierung der in den Berichten erwähnten Orte als geographische Bezüge ausgezeichnete Schlagworte und Abfassungsorte. Sowohl Timlines als auch Kartendarstellung sind Ausgabetypen von Abfragen, die von Semantic Results Formats zur Verfügung gestellt werden. Als Kartendienst für den Ausgabetyp „Maps“ wird Leaflet verwendet. Als eingebettete Karten-Overlays kommt "Esri.WorldShadedRelief" zum Einsatz (Tiles © Esri). Es handelt sich hierbei um ein modernes (keine historischen!) Kartenset. Durch die weitestgehend neutrale Darstellung (nur Höhenrelief und Gewässer) werden jedoch die BetrachterInnen nur in möglichst geringem Maße durch moderne Grenzen und Infrastrukturen beeinflusst.

Das Wiki-interne Schema greift auf Kategorie, Attribute und Subobjekte zurück. Alle Entitäten, Träger von Informationen, werden als Seiten angelegt. Die grundlegenden Entitäten sind dabei Werke und die dazugehörigen Berichte (Quellenstellen). Folgende Konventionen kommen dabei zur Anwendung:

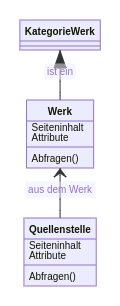

- Seiten sind typisiert/klassifiziert durch die Zuordnung zu einer Kategorie, d. h. diese repräsentieren eine „ist ein“-Beziehung (s. Abbildung 1).

- Beziehungen zwischen Entitäten werden durch Attribute ausgedrückt, überwiegend in sprechender gerichteter Form (z. B. „aus dem Werk“, s. Abbildung 2).

Das Gesamtnetz der Beziehung, ausgedrückt als Klassendiagramm, ist in Abbildung 3 dargestellt, Hieraus wird ersichtlich, dass die Entitäten „Werk“, „Quellenstelle“, „VerfasserIn“, „Person“, „Ort“ („Geographicum“) die primären Informationsträger sind (s. Abbildung 4 „Kernmodell“). Die Seitentypen „Auffälligkeit“, „Schlagwort“, „Abfassungsregion“ stellen Hilfskonstrukte dar, auf die referenziert wird und die Informationen aggregieren, aber selbst keine Informationen tragen.

Attribute sind im SMW typisiert, d. h. dass das Verweisziel von Attributen einem Datentypen zugewiesen wird (s. SMW Properties and Types). Für die vollständige Liste der verwendeten Attribute und deren Datentypen s. Projekt- und Datengenese.

Um die Erstellung von redundanten Inhalten zu vermeiden, wurde die Entscheidung getroffen, mehrfach Zuweisung von Typen/Klassen zu erlauben, und damit eine gewisse semantische Unschärfe in Kauf genommen: Geographische Entitäten und Schlagwörter mit geographischem Bezug können sich überschneiden, siehe z. B: „Babylon“.

Subobjekte kommen in einem isolierten Anwendungsfall zum Einsatz: Quellenstellen können über mehr als ein Ereignis berichten, diese wiederum unterschiedlich datiert werden. Dies kann nicht über Seiten-Attribute abgebildet werden, da Attribute von einem Typ nicht wiederholbar sind. Die maschinenlesbare Angabe von Zeiträumen (ZeitangabeBeginn, ZeitangabeEnde) wird also in ein oder mehrere Subobjekte der jeweiligen Quellenstellen „ausgelagert“.

Wiederkehrende Elemente, insbesondere Infoboxen, und sich wiederholende Erläuterungstexte werden als Wiki-Templates realisiert, um eine einheitliche Darstellung zu erzeugen, die an zentraler Stelle gepflegt und angepasst werden kann, ohne Einzelseiten bearbeiten zu müssen.

Aufbereitung und Import

Die Ausgangsdaten („XML-Masterfassung“) wurden durch eine Reihe von XSL-Transformationen aufbereitet, in Wikisyntax übersetzt und in das Mediawiki importiert.

Die Skripte lassen sich nach vier Funktionen einteilen:

- Kurationsskripte, die auf die Datenbasis angewandt werden, um Datenkorrekturen, -angleichungen und -anreicherungen vorzunehmen.

- Anreicherungsskripte, die Information aus der Datenbasis gegen externe Quellen, insbesondere Normdatenkataloge, abgleichen und aus diesen zusätzliche Informationen in die Datenbasis integrieren.

- Erstellen der kompakten Visualisierung von Datierungen zu den einzelnen Werken.

- Import-Pipeline, die die Transformation in Wikisyntax und Import in das Mediawiki operationalisieren.

Kuration

Systematische Datenkorrekturen und -angleichungen mittels XSL-Transformationen, insbesondere das Nachhalten von eindeutigen Verknüpfungen zwischen Entitäten, die im Volltext/Übersetzung der Quellenstellen ausgezeichnet sind mit den Registereinträgen.

- Ergänzung von IDs für ausgezeichnete geographische Bezüge auf Quellenebene aus dem Orts-Register in der XML-Datenbasis,

- Ergänzung von XML-Auszeichung der Entitäten im Volltext und Volltext-Übersetzung der Quellenstellen in der XML-Datenbasis, Ergänzung von ID und Typ der Entität aus dem Register,

- Angleichung der XML-Datenstruktur an das Datenmodell,

- Ergänzung von Links zu Volltextdigitalisaten in der dMGH.

Normdaten/Anreicherung

Anreicherung der Daten durch Mapping zu Normdaten und externen Ressourcen

- Ergänzung von dMGH-Links. Die Werk-Seiten referenzieren, wann immer möglich, auf den edierten Volltext der Monumenta Germaniae Historica (MGH) (s. „Editionshinweis“ auf den Werk-Seiten), die in der dMGH als Digitalisate verfügbar sind. Die Editionshinweise verweisen in einem einheitlichen Zitationsschema auf die jeweiligen Bände der MGH. Ein XQuery-Programm parst dieses Zitationsschema und gleicht die Angaben gegen die REST-Schittstelle der dMGH ab. Die dMGH-Schnittstelle liefert stabile Referenzen zu den Textstellen, die in die Daten integriert werden und als seitengenaue Verlinkungen auf die dMGH im Wiki angezeigt werden.

- Anreicherung der Orte über Getty TGN. Alle erfassten Toponyme wurden, wann immer möglich, zunächst manuell primär mit Einträgen im Getty Thesaurus of Geographic Names (TGN) verknüpft. Über die Schnittstelle des TGN werden die Koordinaten und die Beschreibung aus dem TGN abgerufen, in die Daten integriert und im Wiki angezeigt.

- Verknüpfung Personen mit der GND und Entity Reconciliation. Die im Register erfassten Personen und VerfasserInnen wurden primär durch die Verknüpfung mit der Gemeinsamen Normdatei (GND) identifiziert. Um den langwierigen manuellen Prozess des Abgleichs mit der GND zu beschleunigen, wurde das Tool OpenRefine im Zusammenspiel mit der OpenRefine-Schnittstelle zur GND des Hochschulbibliothekszentrums (HBZ) des Landes NRW (lobid-gnd) eingesetzt („Entity Reconciliation“).

- Mapping zwischen GND, TGN, VIAF und Anreicherung über Wikidata. Die primäre Normdatenverknüpfung von Orten mit dem TGN und Personen mit der GND dient als Ausgangspunkt für das Mapping von Normdatenverknüpfungen über Wikidata. Hierfür wurde die SPARQL-Schnittstelle von Wikidata abgefragt, um korrespondierende Einträge in anderen Katalogen ausfindig zu machen. Soweit verfügbar ist somit für alle Entitäten eine Referenz zur GND, TGN, Wikidata und den Virtual International Authority File (VIAF®) gegeben. Für Personen/VerfasserInnen wird soweit verfügbar das Feld „Description“ aus Wikidata in die Daten integriert und im Wiki angezeigt.

Visualisierung

- Erstellen einer kompakten SVG-Visualisierung durch XSL-Transformation aus der XML-Datenbasis, die Abfassungszeitraum, Berichtszeitraum und Datierungen aufgenommener Quellenstellen in Relation zueinander darstellen. Die kompakte Darstellung fokussiert auf die Untersuchungszeit des Projekts (7. bis 11. Jahrhundert).

Zusammenführung und Wiki-Import

Generieren von einzelnen Wiki-Seiten aus der XML-Masterfassung in Wikisyntax, Hinzufügen der Annotationen/Relationen und Bulk-Upload der Seiten in das Mediawiki.

- Erstellen der Werkseiten in Wikisyntax aus der XML-Datenbasis, Hinzufügen der SVG-Visualisierung, Einfügen des Infobox-Template-Aufrufs, Einfügen von Entitäten als Attribute in den Volltext, Hinzufügen von zusätzlichen Annotationen (Attributen) durch set-Anweisung, Aufruf Template Infobo und Einbindung der semantischen Abfragen.

- Analog: Quellenstelle, Person, VerfasserIn.

- Erstellen der Registerseiten, d. h. der Hilfsseiten wie „Auffälligkeit“ oder „Schlagwort“, auf die referenziert wird mit entsprechenden Abfragen.

- Generieren von Seiten für alternative Schreibweisen (Alternativnamen) und Einrichten von Weiterleitungen auf die jeweilige primäre Seite.

- Export aller Seiten im XML-Wiki-Import-Format in einer XML-Datei.

- Aufteilen der Seiten in 1000er-Blöcke und Bulk-Import der Seiten nach 1000er-Blöcken.